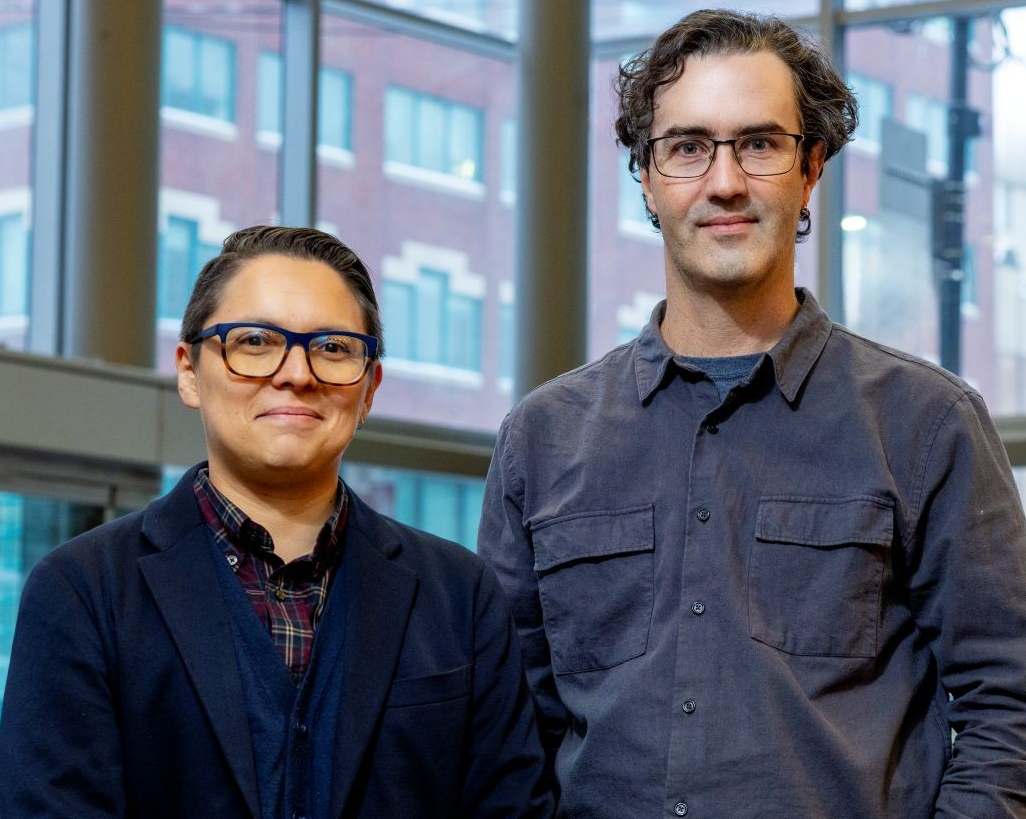

« Il est encore trop tôt pour avoir recours à l’intelligence artificielle en justice criminelle », affirme une doctorante de l’Université Concordia

L’intelligence artificielle (IA) est sur le point de remodeler notre monde de multiples façons et dans presque tous les domaines, incluant le système de justice pénale. La prise de décisions fondée sur les algorithmes et les données est de plus en plus répandue aux États-Unis à l’étape de l’évaluation du risque préalable aux procès, en tant qu’outil de vérification du risque de récidive des personnes contrevenantes. Les partisans de cet usage affirment que le recours à l’IA permet d’éliminer les préjugés inhérents aux divers intervenants du système de justice pénale, comme la police, les juges ou les procureurs.

Toutefois, un récent article de la doctorante de l’Université Concordia et avocate criminaliste Neha Chugh vient remettre en question cette affirmation. Dans son article, Me Chugh soutient que les outils d’évaluation du risque fondés sur l’IA, qui ne sont pas encore en usage dans les tribunaux canadiens, présentent de multiples aspects préoccupants que le système de justice se doit d’examiner. Elle ajoute que les défendeurs autochtones, qui sont déjà surreprésentés dans le système de justice pénale, sont particulièrement vulnérables aux lacunes de l’outil.

Dans son texte paru dans l’IEEE Technology and Society Magazine, Neha Chugh fait référence à l’importante cause Ewert c. Canada pour illustrer les problèmes que comportent les outils d’évaluation du risque en général. Jeffrey Ewert est un Métis qui purge une peine d’emprisonnement à perpétuité pour meurtre et tentative de meurtre. Il a plaidé avec succès devant la Cour suprême du Canada que les tests utilisés par le Service correctionnel du Canada étaient empreints de préjugés culturels à l’encontre des détenus autochtones, avec pour conséquence que ces détenus demeuraient plus longtemps en prison et purgeaient leur peine dans des conditions plus restrictives que les détenus non autochtones.

« La cause Ewert nous indique que les procédures de prise de décisions fondées sur les données doivent faire l’objet d’un examen visant à vérifier l’exactitude des renseignements de départ — et les fondements scientifiques du choix de ces renseignements — et montre en quoi les préjugés existants influent sur les renseignements générés par ces outils », affirme Me Chugh.

« Si nous savons que la discrimination systémique afflige nos communautés et entraîne des inexactitudes dans les données de la police, alors comment pouvons-nous être certains que les données qui alimentent les algorithmes vont générer des résultats fiables? »

« Les partisans de ce type d’utilisation de l’IA renverront la responsabilité des lacunes aux concepteurs de l’algorithme », affirme Neha Chugh.

« Les partisans de ce type d’utilisation de l’IA renverront la responsabilité des lacunes aux concepteurs de l’algorithme », affirme Neha Chugh.

Subjectivité nécessaire

Le recours à l’IA pour procéder à l’évaluation du risque consisterait dans les faits, selon Neha Chugh, à transférer des préjugés humains vers des algorithmes créés par des humains. L’utilisation de données de départ de mauvaise qualité entraîne inévitablement des résultats de mauvaise qualité. « Les partisans de ce type d’utilisation de l’IA renverront la responsabilité des lacunes aux concepteurs de l’algorithme. »

Me Chugh mentionne qu’on songe déjà à faire appel à l’IA dans certains tribunaux canadiens. En tant que membre du Conseil des gouverneurs de la Commission du droit de l’Ontario, elle admet éprouver des réserves face à l’ouverture manifestée par la commission quant à l’usage de l’IA dans le cadre de procédures judiciaires administratives ou d’enquêtes policières.

L’un des principaux inconvénients que Neha Chugh attribue à un recours excessif à l’IA pour l’évaluation du risque et d’autres fonctions est la disparition de la discrétion subjective et de la déférence du processus judiciaire que cette pratique entraînerait. Or, fait-elle remarquer, ce sont là des piliers essentiels à l’indépendance du système judiciaire. Les lois et les statuts fournissent des paramètres à l’intérieur desquels les juges peuvent rendre leurs décisions, tout en leur laissant une certaine latitude qui leur permet de prendre en compte des facteurs pertinents comme l’histoire personnelle et les circonstances individuelles.

« Je crois fermement à l’autorité de nos tribunaux, et que les décisions relatives à la détermination de la peine et aux libérations sous caution sont prises en fonction des intérêts de la communauté et des circonstances propres à chaque cas », affirme-t-elle.

« Nous nommons nos juges et nos décideurs en tenant compte de leur connaissance de la communauté. Avons-nous besoin d’externaliser ce processus de prise de décisions vers un système fondé sur de grands ensembles et des caractéristiques générales? Ou tenons-nous à nous appuyer sur un système où il est possible d’avoir des échanges personnalisés avec les contrevenants? Je préfère la seconde avenue, car je crois que les tribunaux peuvent avoir un impact important sur les personnes. »

Neha Chugh insiste pour dire qu’elle n’est pas complètement contre le recours à l’IA dans le système judiciaire, mais qu’à son avis, des recherches plus approfondies s’imposent.

« Sommes-nous arrivés à l’étape de la mise en œuvre? Selon moi, non. Mais si l’on me prouve que j’ai tort, je n’hésiterai pas à changer d’avis. »

Lisez l’article cité : « Risk Assessment Tools on Trial: AI Systems Go? ».